Meine Gebete wurden erhört 🙂 Wie durch ein Wunder ging der SEO Pokal für die beste SEO Content Marketing Kampagne in diesem Jahr nicht nach München, sondern ins beschauliche Holzwickede. Das Team von Uniq konnte die Fachjury mit dem Projekt „Deutschlandliebe“ überzeugen. Mit den klaren Content-Strukturen auf einer bereits starken Branchen-Domain, leicht verdaulichem- und ansprechendem Content sowie einer technisch sauberen Umsetzung, wenn auch noch weit von perfekt entfernt, treffen die /deutschlandliebe/* – Seiten augenscheinlich den Google-Zahn der Zeit. Offpage zeigt sich ein Mix aus guter PR, internem Network-Cross-Linking, earned Links, triggered Links, umgelenkten Link-Juice aus dem Reisemagazin… ebenso vertreten sind ein paar miese Links sowie ein klein bisschen Paid.

Huch: alter Wein in neuen Schläuchen?

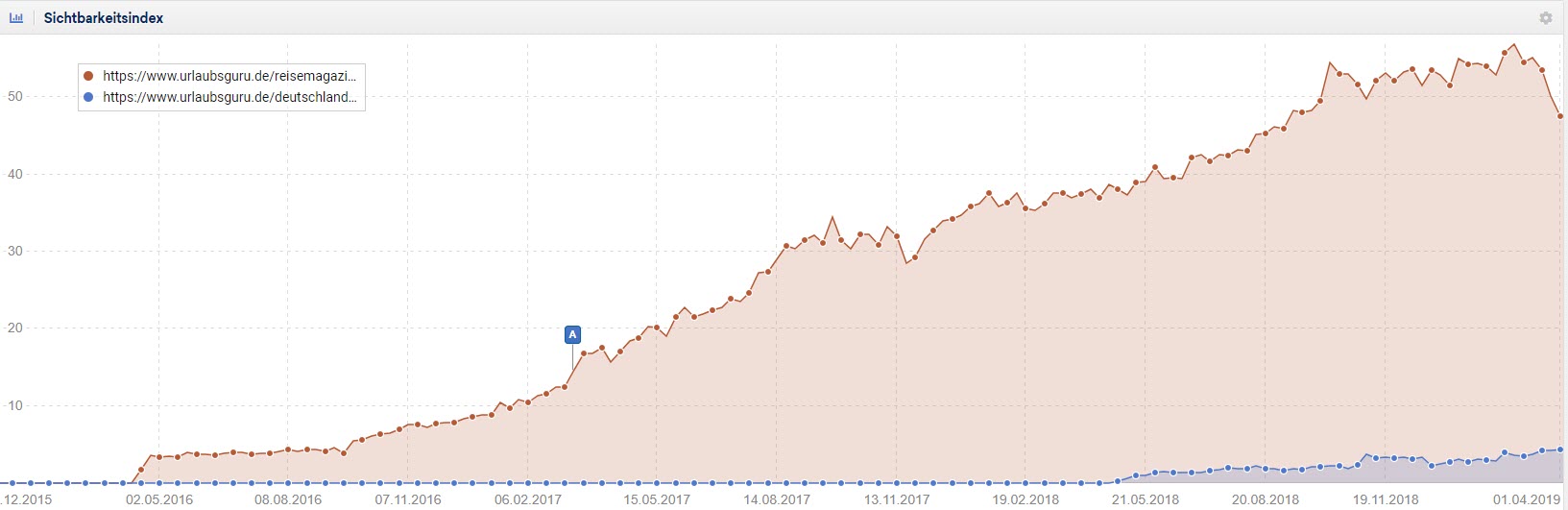

Auffällig bei der Offpage-Analyse sind die umgezogenen Artikel aus dem Reisemagazin. Während /deutschlandliebe/ es auf gute 4 Sichtbarkeitspunkte schafft, verliert hat das /reisemagazin/ seit Ende Februar 2019 gute 9 Sichtbarkeitspunkte verloren – ein rechnerischen Netto-Sichtbarkeitsverlust von 5 Punkten, um mal bei den Punkten zu bleiben. Irgendwie auch logisch, wenn man Artikel aus dem /reisemagazin/ nach /deutschlandliebe/ umzieht, dass der eine verliert und der andere gewinnt, oder?

Quelle: Sistrix Toolbox

Quelle: Sistrix Toolbox

Aus www.urlaubsguru.de/reisemagazin/silvester-in-berlin/ wird www.urlaubsguru.de/deutschlandliebe/silvester-in-berlin/ der Kreidefelsen aus Rügen wandert von www.urlaubsguru.de/reisemagazin/kreidefelsen-auf-ruegen/ auf www.urlaubsguru.de/deutschlandliebe/kreidefelsen-auf-ruegen/ usw. Die interne Verlinkung wird dabei direkt gerade gezogen, wie man bei diesem Artikel aus Mitte 2017 sieht: https://www.urlaubsguru.de/reisemagazin/berlin-tipps-fuer-ein-traumhaftes-wochenende/ – einer Zeit als es das Projekt /deutschlandliebe/ noch nicht gab.

Die Strategie sieht mir mehr nach einer Umstrukturierung des Reisemagazins (Content-Recycling) aus, in dem extrem viel Content schlummert und nun in ein sinnvolleres, thematisch besser passendes Raster gepresst werden soll. Kombiniert mit ein wenig (Content)-Marketing-Buzz und einem Layout-Rebrush, angereichert mit neuen Inhalten und ergänzt mit bestehenden aus dem Reisemagazin – schafft man eine gute Frequenz an Inhalten und gleichzeitig fließt Deep-Link-Juice in die neue Struktur.

Was bleibt ist der Nettoverlust an SI im Magazin. Das neue Folder kann den Rückgang aktuell noch nicht ausgleichen. Aber Sichtbarkeit ist ja auch nur ein SEO Wert von Vielen.

Herzlichen Glückwunsch zur Besten SEO/Content Marketing Kampagne 2019.