Google hat im Moment die Eigenart neue Seiten und speziell Blogs mit einem extrem heftigen Newbiebonus zu versehen und die Beiträge sehr gut im Googleindex zu ranken. Selbst bei harten Keywords sieht man funkelnagelneue Blogs häufig vor Seiten wie Spiegel, Golem etc.

Bei vielen Bloggern bricht auf Grund des massiven Traffics eine wahre Euphorie aus, „findige“ Blogger wittern hier das schnelle Geld und spicken Ihre Beiträge mit allem womit man Geld machen kann, bishin zu schicken Layern, dass nur mal nebenbei.

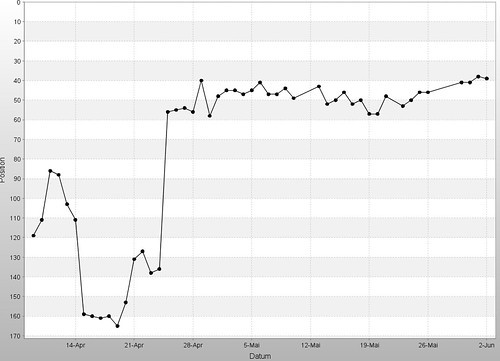

Dann urplötzlich nach Wochen oder Monaten, kaum noch Traffic, Blog nicht mehr oder kaum noch zu finden bei Google, ab ins Nirvana. Es scheint so dass Google die Blogs erstmal eine zeitlang gut listet um die Qualität des Traffics – nach welchen Kriterien auch immer – zu analysieren und sie dann auf die hinteren Ränge schickt. Einige rutschen von Top Positionen bis auf Plätze hinter 500 ab, andere verlieren weit aus nicht soviel, dass scheint an der vorher analysierten Qualität des Traffics festgemacht zu werden und evtl. noch wie kommerziell ein Blog betrieben wird oder nicht.

Nun kommt Phase 2, wenn der Blog abgeschmiert ist scheint Google zu checken ob der Blog sich weiterhin regelmäßig über neue Beiträge freuen darf oder ob Funkstille ist. Schreibt man weiterhin seine Beiträge darf man sich bald wieder über gute Positionierungen freuen, stellt man das schreiben gänzlich ein wird man ewig auf eine Neusortierung warten.

Dieses relisting kann von einigen Wochen bishin zu mehreren Monaten dauern, ausschlaggebend ist hier meiner Meinung nach die Anzahl der Beiträge die man nach dem abschmieren postet, bzw. ob diese dem Verhalten bei noch guten Positionen gleichkommt oder ähnelt.

Letzte Nacht ist sogar eine ältere Seite hinter die seit kurzem ein Blog geschaltet wurde abgerauscht, schaun wir mal.

Update: hier das ganze mal Live zu beobachten: Video Voting, gerade ein paar Tage alt, traumhafte Positionen, z.B.: Windows Fehlermeldung von Null in die Top Ten eingetaucht, Traffic von Null auf knapp 1K am Tag. Mal sehen wie lange es dauert bis der stirbt.