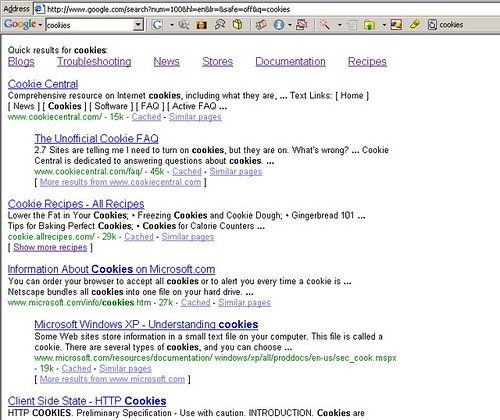

Google ist derzeit mal wieder am testen, diesmal geht es um Quick Results die über den Serps anklickbar eingeblendet werden.

Ein Klick auf die entsprechenden Tags, leitet zu einer Google Abfrage wie z.B.:

cookies more:troubleshooting

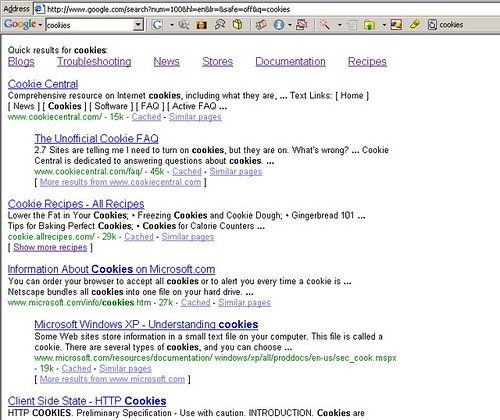

Google ist derzeit mal wieder am testen, diesmal geht es um Quick Results die über den Serps anklickbar eingeblendet werden.

Ein Klick auf die entsprechenden Tags, leitet zu einer Google Abfrage wie z.B.:

cookies more:troubleshooting

In den letzten Tagen erhielt ich hier massiv Statistik Spam, jeder Zugriff mit wechselnder IP und geläufigen User Agents, so das ich die nicht so einfach per .htaccess sperren kann.

Hier hab ich folgende Lösung gefunden, ohne die Domains immer jeweils einzeln Sperren zu müssen. Hier mal eine Beispiel .htaccess

Mal testen, scheint aber bis jetzt ganz gut zu funktionieren.

Nach unser Tochter Lisa, das Mädchen was ewig Wuugal brabbelt (was wohl Google heißen soll) – dessen kreative Wortschöpfung Google nach wie vor in keinster Weise anerkennt – wurde heute um 15:05 Uhr unsere Tochter Lena Marieke geboren. Lena wiegt 3920 Gramm und ist 53cm groß und alle sind wohl auf.

Naj ich werde versuchen das Mädel solange wie möglich von diesem komischen Eingabegerät mit Bildschirm fernzuhalten und sehen das das Mädel einen anständigen Beruf erlernt. 🙂

Da ich heute zu faul zum schreiben bin, hier mal ein bisschen Google TV, ein Promo Video von Google.

Filmrezensionen gibts dazu noch keine, naja aber wer Lust hat kann ja eine schreiben 🙂

Thomas Zeithaml ein nettes Tool gebastelt auf das wohl viele Webmaster schon lange gewartet haben, gerade wohl auch diejnigen die aufgrund von Duplicate Content durch Spambots verursacht ihre Seiten nur noch auf den hinteren Rängen wiederfinden.

Spidertrap ist eine Falle für genau diese bösen Bots / Spambots, die Installation und Anwendung ist denkbar einfach. Man installiert spider-trap auf dem Server und setzt einen Link von der Seite, z.B. in Form einer Grafik wie hier oben rechts zu sehen, mit einer 1px Grafik, oder mit einem normalen Textlink oder …

Dieser Link verweist nun in das Verzeichnis /spider-trap/ auf dem Server, jetzt verbietet man mithilfe der robots.txt den entsprechenden Bots den Link zu folgen, also z.B.

User-agent: *

Disallow: /spider-trap

Also in diesem Fall hat kein Bot diesen Link zu verfolgen, gute Bots halten sich an die robots.txt, böse Bots halten sich meist nicht an die robots.txt und werden diesen Link verfolgen und landen im Verzeichnis /spider-trap/, sind also in die Falle getappt. Ist der Bot in die Falle gegangen, schreibt Spider Trap ein deny from in die .htaccess und der Bot ist für die komplette Seite gesperrt. Um dort wieder rauszukommen müsste er ein Wort auf der spider-trap/index.php eingeben, bei uns wäre das Wort mensch. Klickt also ein Besucher auf den Link, kann er seinen deny from durch Eingabe des vogegebenen Wortes entfernen und hat somit wieder vollen Zugriff auf die Seite, ein Bot kann dieses natürlich nicht und bleibt somit gesperrt.

Auch Google hält sich ja manchmal nicht an die robots.txt, um den Googlebot nicht ausversehen einzufangen, gibt es eine Whitelist in der man über den Useragent definieren kann wer nie eingefangen werden darf, also Googlebot, slurp usw. Über die Whitelist könnte man auch nur die gewünschten Bots zulassen und alle anderen komplett in die Falle tappen lassen. Will man z.B. nur den Googlebot zulassen, könnte man das so machen.

robots.txt:

User-agent: *

Disallow:

also alle „dürfen“ in die Falle

und Whitelist mit dem Eintrag: Googlebot, das wäre dann die ganz harte Nummer 🙂 Hier gibt es noch wesentlich mehr möglichkeiten, welche auf Spider Trap genauer beschrieben werden.

Wir haben das die letzten Tage mal ausgiebig getestet, so sind z.B. auf no-nofollow.de nach nur kurzer Zeit knapp 20 böse Bots in die Falle gegangen, die Kollegen kamen aus allen Ländern. China, Korea, Rußland, USA usw. und hatten sicherlich nichts gutes vor. Wenn man möchte kann man sich auch automatisch per mail informieren lassen wenn jemand in die Falle geht.

Fazit: Ein Super Tool, einfach zu installieren, kostenlos!

Mehr dazu, wie Download, Installationsanleitung, Funktionsweise sowie eine Möglichkeit böse Bots zu melden und bereits gemeldete in einer Übersicht zu sehen gibts direkt auf Spider Trap

Viel Spaß beim Spambot fangen 🙂

Wer es mal ausprobieren möchte, der klicke hier auf die Spinne.

Google beachtet seit neustem nun scheinbar das rel=“nofollow“ Attribut garnicht mehr. Versieht man z.B. interne Links mit dem nofollow Attribut um sich so vor duplicate content zu schützen, bzw. der Seite keine Nennenswerte Stärke zu verleihen, werden diese Links nun scheinbar trotzdem ganz normal verfolgt und gewertet. Also Sie erscheinen in den Serps, sind im Cache und werden bei der Suche auch ganz normal gefunden.

Hier mal ein Beispiel:

z.B. Das Impressum von Chip mit rel="nofollow" versehen: www.chip.de/c1_impressum/c1_impressum_13396268.html, PR6, sucht man nach Poccistraße 11 wird die Impressum Seite auch bestens gelistet.

Das Beispiel ist blöd da die Seite auch noch normal verlinkt ist, schaut vielleicht einfach mal auf euren eigenen Seiten.

Auch auf unseren Seiten sind viele mit nofollow versehenden Links ganz normal in den Serps und bestens gelistet. Auch bei externen mit nofollow versehenden Links erscheinen die Zielseiten ganz normal mit voller Kraft in den Serps.

Google sagt ja selbst:

From now on, when Google sees the attribute (rel=“nofollow“) on hyperlinks, those links won’t get any credit when we rank websites in our search results

Ich sag ja Google ist kaputt 😉

Seit heute bekommt man nur noch ein Ergebnis angezeigt, wenn man „domain.de“ im Google Suchschlitz einwirft, früher funktionierte das nur bei der Eingabe mit www.

So liefert die Suche nach ebay.de nur noch ein Ergebnis. Das wird viele Leute sicherlich nicht sonderlich freuen, da der eine oder andere ja speziell auf Domainnamen, also z.B. ebay.de optimiert hatte und damit sicherlich nicht schlecht gelebt hat(te).

So mal wieder ein Warnschuss an aller Spammer aus Googles Anti Spam Labor. Dort wird halt gezeigt was man nicht machen sollte und als Beispiel die Seite automobile.de genommen, die sich nun nicht mehr im Google Index befindet.

Naja und weiter heißt es, dass Google sich 2006 deutlich stärker um Spam in anderen Sprachen kümmern will und Matt empfiehlt allen Webmastern Ihre Seiten nochmal gründlich auf Spammethoden zu prüfen und diese zu bereinigen bevor Sie aus dem Index fliegen:

If you work at a large company that has doorway pages, keyword stuffing, or other tricks against our webmaster quality guidelines in a non-English language, consider this a courtesy notice that Google will paying a lot more attention to spam in other languages in 2006. Please check your site for issues now to avoid any potential problems.

Auch ne Art von Spambekämpfung, jetzt wo eine deutsche Seite als Beispiel gezeigt wurde, werden wohl einige Webmaster hierzulande kalte Füsse kriegen und schonmal Ihre Seiten rückrüsten.

Kürzlich hatte ich ja über die Zahlungsschwierigkeiten und den Verkauf von der Touristikbörse berichtet. Offen war da ja noch wer der neue Gesellschafter ist und vor allem was mit den austehenden Zahlungen der ganzen webmaster passieren wird. Soeben gabs eine offilzielle Pressemitteilung der Touristikbörse, hier mal einige Auszüge:

Die Touristikboerse Deggendorf, mit www.affilian.de Marktführer im Vertrieb von Pauschalreisen über Affiliate oder Partner Programme in Deutschland, hat einen neuen Gesellschafter gefunden. Axis Data, ein spanisches Unternehmen mit Schwerpunkt in Entwicklung und Betrieb touristischer Datenverarbeitungssysteme, hat mit gestrigem Datum den gesamten Geschäftsbetrieb der Touristikboerse übernommen. Die Gesellschaft firmiert nunmehr unter traviaNET GmbH touristikboerse.

….

Wir freuen uns, Ihnen zum kurzfristigen Ausgleich der Werbekostenzuschüsse folgendes Angebot unterbreiten zu können:

Auszahlung aller bereits abgerechneten WKZ`s bis spätestens 18.01.2006.….

Voraussetzung für eine Auszahlung unsererseits ist lediglich Ihre Zustimmung, dass Ihr Vertrag mit der Touristikbörse Deggendorf auf die traviaNET GmbH touristikboerse übergeht.

Als erfolgreich durchgestartet wird das neue Produkt von Abacho, Abacho4you beworben.

Abacho selber schreibt zu seinem neuen Produkt:

Abacho4you ist eine revolutionäre Websuche, die Sie an Ihr bestehendes Seitendesign anpassen können. Sie erzielen einen deutlichen Mehrwert Ihrer Seite und eine höhere Kundenbindung über die hochwertige Suchfunktion.

Wer möchte kann dann sogar noch Geld verdienen damit, indem man Werbung in der Suche einblendet und somit Dienste der Abacho AG, wie z.B. my Hammer bewirbt und „kassiert“ 0,50 Euro TKP.

Tja Google nun wirds eng 😉

Hab mir da doch gleich mal schnell ne eigene kostenlose Suchmaschine bei Abacho gebastelt, kostenlos und werbefrei bannerfrei. Nur schade das ich nicht von den Overture Einnahmen abbekomme, naja dafür darf ich die ja kostenlos nutzen. 😉