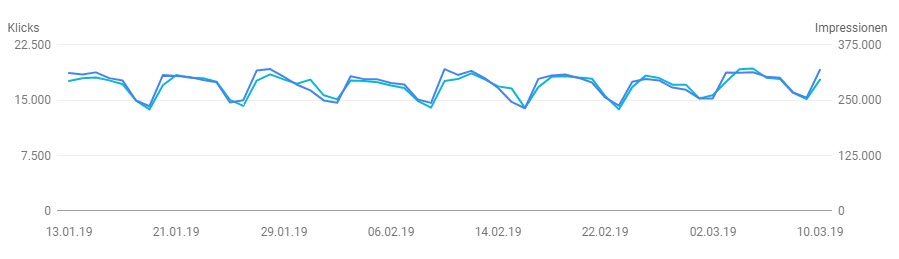

Jeder der sich mal ein wenig mit den Traffic-Zahlen seiner Webseite beschäftigt hat kennt Bilder wie diese:

Jeden Tag suchen ungefähr gleich viele Menschen nach total unterschiedlichen Suchbegriffen und zufällig sind das – Wochentag zu Wochentag verglichen – nahezu exakt soviele wie am selben Wochentag zuvor… Im obigen Beispiel sehen wir 300.000 tägliche Suchanfragen, bestehend aus täglich 200.000 völlig unterschiedlichen Suchbegriffen und keiner von den schlauen Leuten da draußen wundert sich über diese statistische Geradlinigkeit auf der man locker eine Tasse Kaffee abstellen kann?

Doch, ein paar schlaue Leute gibt es jedes Jahr. Sie stellen sich dann die Frage: Könnte es möglich sein, dass Google den Traffic deckelt, dass es eine Art Traffic-Limit bei Google in der organischen Suche gibt und Google über die Vielzahl an Begriffen steuert, wie viel Traffic eine Seite bekommt? Steuert Google so etwa den wirtschaftlichen Erfolg oder Mißerfolg verschiedener Seiten?

Jedes Jahr schafft es dann auch einer von den schlauen Leuten seine Frage in einem Google-Frage-Antwort-Format zu präsentieren und jedes Jahr dementiert Google und sagt, dass kein Traffic-Counter für Seiten existiert und keine Traffic-Bremse in den Algorithmus eingebaut wurde. Die Geradlinigkeit ist völliger Bullshit und existiert gar nicht, schau halt woanders hin.

Wir sagen stimmt. Ein organisches Traffic-Limit für eine Seite existiert nicht. Es ist vielmehr ein CTR Limit welches an die (Sub)Domain gekoppelt ist:

Schaut einfach selbst… seid ihr ein 3% CTR Typ, ein 5% CTR Typ oder eine 7% CTR Typ… Branchen-Gewinner kommen im Schnitt zwischen 7% und 10% ohne Ihre eigene Brand. (Filter Deutschland, damit 80% des ganzen Tool-Bot-Traffic raus fällt).

Die CTR (Click-Through-Rate) bleibt zwischen den Core-Updates ziemlich konstant, selbst wenn sich die „Nachfrage“ in Form der Impressions verändert, auch gemerkt?

Vielleicht erlaucht sich einer der schlauen Leute im kommenden Jahr einfach seine Frage besser zu formulieren – Google, gibt es ein CTR-Limit auf Host-Level? Übrigens kennen wir sowas auch unter den Namen Host-Trust oder Domain-Trust oder Whatever-Trust.

Tipp für alle schlauen Leute mit Seiten ab 200 organischen Besucher / Tag: testet mal diese Hypothese -> wenn die CTR aus Gründen mal für einen kurzen Zeitraum einbricht, versucht Google die CTR in den nachfolgenden Tagen wieder hochzuziehen, um auf den zugesicherten Threshold zu kommen…